Juan David Gutiérrez

Profesor Asociado – Coordinador de la Maestría en Políticas Públicas

Ph.D. Políticas Públicas, Oxford University.

En el marco de un contrato con la UNESCO, la Escuela de Gobierno desarrolló un proyecto liderado por el profesor Juan David Gutiérrez para analizar el uso y gobernanza de los sistemas de inteligencia artificial (IA) en el ámbito jurídico y redactar las primeras directrices globales sobre el uso de estas herramientas para la administración de justicia.

La iniciativa tuvo dos resultados complementarios. En primer lugar, se diseñó y aplicó una encuesta global dirigida a operadores judiciales sobre el uso de sistemas de IA en el sector de la justicia (UNESCO Global Judges’ Initiative: survey on the use of AI systems by judicial operators). En segundo lugar, se elaboraron directrices internacionales para orientar el uso de estos sistemas en cortes y tribunales (UNESCO Guidelines for the Use of AI Systems in Courts and Tribunals.) El proyecto se apalancó en la evidencia empírica recopilada y en las contribuciones de cientos de operadores judiciales de todo el mundo para ofrecer un diagnóstico de los retos del uso y la gobernanza de las herramientas de IA en el sector de la justicia y desarrollar las directrices de uso de estas tecnologías.

La encuesta se realizó entre septiembre y diciembre de 2023. Participaron 563 operadores judiciales de 96 países, entre ellos jueces, fiscales, abogados, funcionarios de la administración de justicia e investigadores.

Entre los principales hallazgos de la encuesta, se destacan los siguientes:

Familiaridad con las tecnologías de IA

El 31% de los encuestados se consideraba “experto” o “muy familiarizado” con los sistemas de IA, el 41% contestó que estaba “moderadamente familiarizado” con la IA, y el 27% estaba “un poco o nada familiarizado”.

Uso profesional de herramientas de IA

El 44 % reportó haber utilizado herramientas de IA en actividades relacionadas con su trabajo y el 41 % indicó haber utilizado ChatGPT u otros chatbots.

En términos de frecuencia, el 20 % señaló haberlas utilizado solo algunas veces, el 13 % reportó un uso semanal o mensual y el 11 % un uso diario. No obstante, el 53 % indicó no haber utilizado herramientas de IA en su trabajo o haberlas utilizado únicamente en actividades no laborales, y el 59 % reportó no haber utilizado chatbots en actividades profesionales.

En relación con el acceso a estas tecnologías, el 16 % reportó acceso institucional proporcionado por su organización, el 71 % indicó haber accedido a versiones gratuitas y el 12 % señaló haber pagado una suscripción.

¿Para qué se utilizan los chatbots?

Entre quienes reportaron utilizarlos, el 43 % indicó que los emplea para la búsqueda de legislación, jurisprudencia, doctrina o información técnica; el 28 % para la redacción de documentos —incluidos resúmenes, correos rutinarios, argumentos legales, traducciones y corrección de textos—; y el 14 % para la lluvia de ideas. En menor proporción, el 5 % reportó utilizarlos para clarificar conceptos complejos, el 4 % para analizar datos, el 3 % para verificar información y el 2 % para programación.

Respecto al uso de los resultados generados por la IA, el 55 % reportó utilizarlos como insumo para redactar sus propios textos, el 39 % indicó que los utiliza después de revisarlos y editarlos, y el 6 % señaló que los utiliza directamente sin verificación previa.

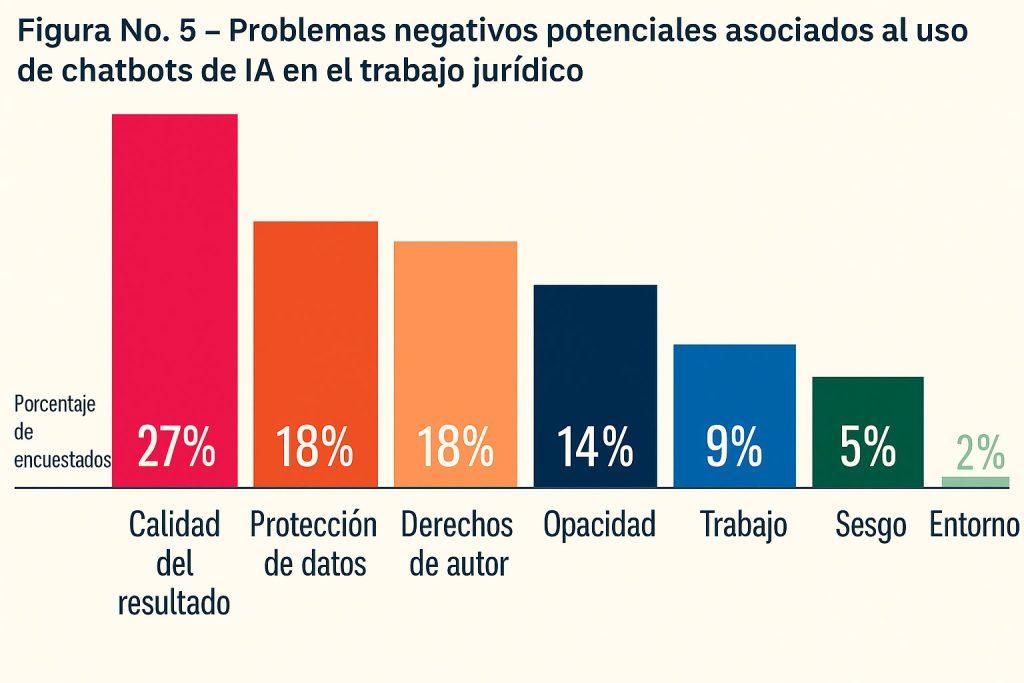

Riesgos y condiciones institucionales

La mayoría de las personas encuestadas consideró que deberían existir reglas obligatorias para el uso de chatbots de IA: el 73 % para jueces y/o fiscales, el 72 % para abogados y el 73 % para funcionarios de administración legal e investigadores. El 92 % consideró relevante que la UNESCO publicara directrices sobre el uso de las herramientas de IA y de IA generativa por parte de los operadores judiciales.

Como resultado del proceso iniciado con la encuesta global a operadores judiciales, UNESCO publicó las Guidelines for the Use of AI Systems in Courts and Tribunals, el primer marco global de carácter ético y operativo orientado específicamente al uso de herramientas de IA en contextos judiciales.

Estas Directrices buscan asegurar que la adopción de sistemas de IA en los cortes y tribunales fortalezca la administración de justicia, proteja el Estado de derecho y garantice los derechos humanos y las libertades fundamentales.

Un marco basado en 15 principios universales

Las Directrices están estructuradas en quince principios que orientan la adopción, la gobernanza y la supervisión de sistemas de IA en el poder judicial. Estos principios deben aplicarse a lo largo de todo el ciclo de vida del sistema desde su desarrollo o adquisición hasta su implementación, evaluación y eventual retiro.

Los 15 principios establecidos son:

Gobernanza y colaboración multiactor:

El documento enfatiza que los sistemas de IA deben actuar como herramientas de apoyo y no como sustitutos del razonamiento judicial. La función jurisdiccional no puede ser reemplazada por sistemas automatizados, y cualquier uso de estas tecnologías debe mantenerse bajo supervisión humana significativa.

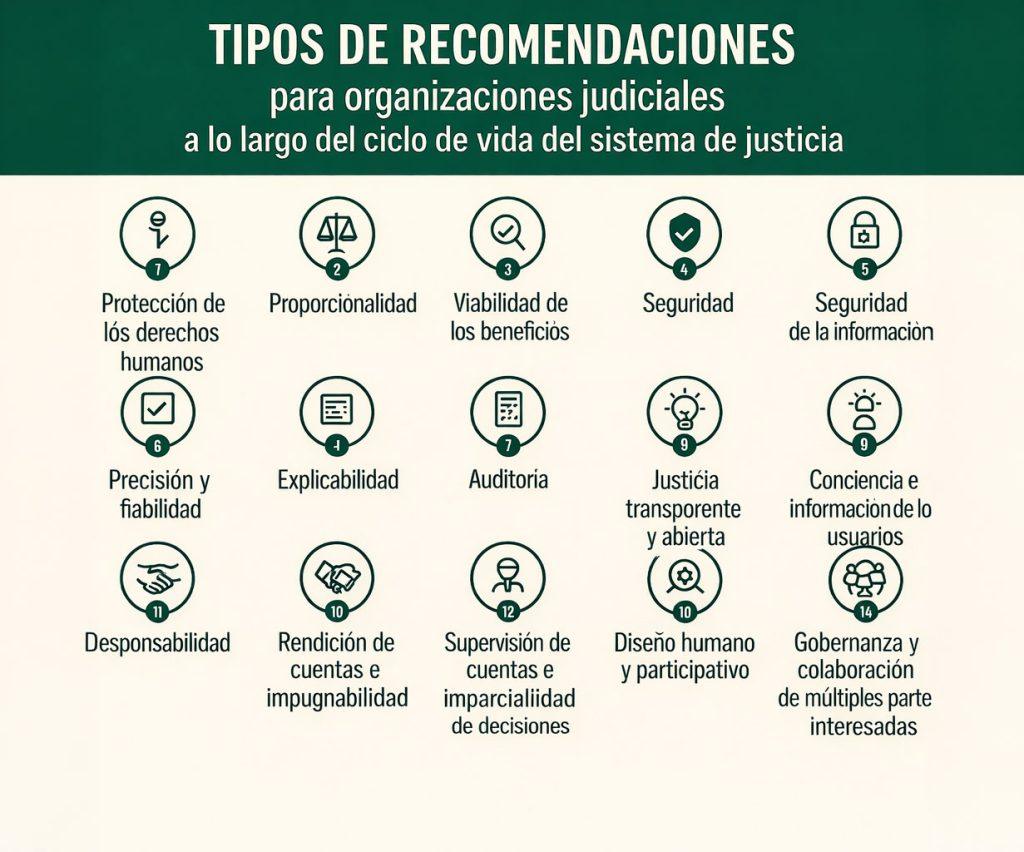

Orientaciones para organizaciones judiciales

Además de los principios generales, las Directrices desarrollan recomendaciones específicas dirigidas a organizaciones del poder judicial —cortes y tribunales— que evalúan, desarrollan, adquieren, utilizan o supervisan sistemas de IA.

Estas recomendaciones se agrupan en tres grandes categorías:

En relación con el ciclo de vida de los sistemas, el documento establece que las organizaciones judiciales deben:

Asimismo, se recomienda realizar evaluaciones de riesgos, establecer mecanismos de supervisión y auditoría, y garantizar que existan salvaguardas cuando los sistemas puedan representar riesgos significativos para los derechos humanos.

Inteligencia artificial generativa en contextos judiciales

Dado el creciente uso de herramientas basadas en modelos de lenguaje de gran escala, las Directrices dedican una sección específica a la IA generativa.

El documento advierte que estas herramientas pueden comunicar en lenguaje natural y generar contenido en respuesta a instrucciones (prompts), pero también pueden producir resultados inexactos o incorrectos. Por ello, establece que:

La IA generativa no debe sustituir peritajes, análisis especializados ni la deliberación judicial.

Capacidades, formación y supervisión humana

Las Directrices subrayan la importancia de fortalecer el talento humano dentro del poder judicial. La alfabetización en IA y la formación especializada son consideradas elementos esenciales para que jueces, magistrados, funcionarios judiciales y personal de apoyo puedan comprender, evaluar y gestionar adecuadamente los riesgos asociados al uso de estas tecnologías.

Igualmente, insisten en que la supervisión humana es un requisito central. La IA puede contribuir a mejorar la gestión de casos, ampliar el acceso a información y aumentar la eficiencia, pero siempre bajo revisión ética y control humano efectivo.

Un documento vivo con alcance global

Las Directrices fueron elaboradas con base en amplios procesos de consulta y formación previos que involucraron a expertos de más de 160 países y a más de 36.000 actores judiciales. Además, se conciben como un documento vivo, sujeto a actualizaciones periódicas para responder a la rápida evolución tecnológica.

En conjunto, este marco ofrece orientación práctica para que las herramientas de IA contribuyan a fortalecer la justicia, la transparencia y la confianza pública, sin comprometer la independencia judicial ni los derechos fundamentales.

Conozca la documentación del proyecto aquí:

Profesor Asociado – Coordinador de la Maestría en Políticas Públicas

Ph.D. Políticas Públicas, Oxford University.